![Python3.x网络爬虫从零基础到项目实战 《Python3.x网络爬虫从零基础到项目实战》[64M]百度网盘|pdf下载|亲测有效](/365baixing/uploads/s0309/2b220624399ca08a.jpg)

![《Python3.x网络爬虫从零基础到项目实战》[64M]百度网盘|pdf下载|亲测有效](/365baixing/uploads/s0309/2b220624399ca08a.jpg)

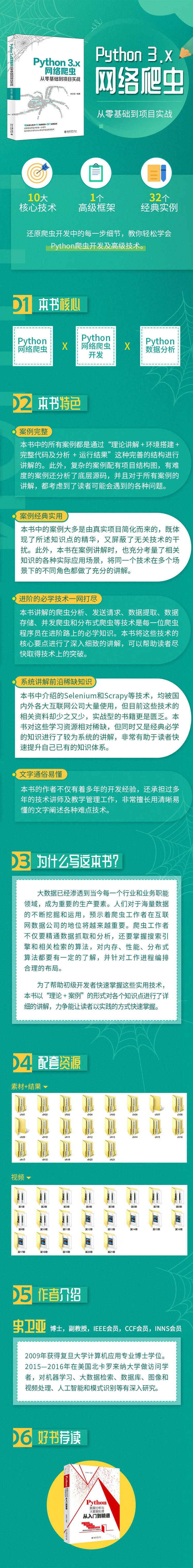

Python3.x网络爬虫从零基础到项目实战 pdf下载

8.99¥

10.99¥

内容简介

本篇主要提供Python3.x网络爬虫从零基础到项目实战电子书的pdf版本下载,本电子书下载方式为百度网盘方式,点击以上按钮下单完成后即会通过邮件和网页的方式发货,有问题请联系邮箱ebook666@outlook.com

编辑推荐

● 案例完整

本书中的所有案例都是通过“理论讲解 + 环境搭建 + 完整代码及分析 + 运行结果”这种完善的结构进行讲解的。此外,复杂的案例配有项目结构图,有难度的案例还分析了底层源码,并且对于所有案例的讲解,都考虑到了读者可能会遇到的各种问题。

● 案例经典实用

本书中的案例大多是由真实项目简化而来的,既体现了所述知识点的精华,又屏蔽了无关技术的干扰。此外,本书在案例讲解时,也充分考量了相关知识的各种实际应用场景,将同一个技术在多个场景下的不同角色都做了充分的讲解。

● 进阶的必学技术一网打尽

本书讲解的爬虫分析、发送请求、数据提取、数据存储、并发爬虫和分布式爬虫等技术是每一位爬虫程序员在进阶路上的必学知识。本书将这些技术的核心要点进行了深入细致的讲解,可以帮助读者尽快取得技术上的突破。

● 系统讲解前沿稀缺知识

本书中介绍的Selenium和Scrapy等技术,均被国内外各大互联网公司大量使用,但目前这些技术的相关资料却少之又少,实战型的书籍更是匮乏。本书对这些学习资源相对稀缺,但同时又是经典必学的知识进行了较为系统的讲解,非常有助于读者快速提升自己已有的知识体系。

● 文字通俗易懂

本书的作者不仅有着多年的开发经验,还承担过多年的技术讲师及教学管理工作,非常擅长用清晰易懂的文字阐述各种难点技术。

本书中的所有案例都是通过“理论讲解 + 环境搭建 + 完整代码及分析 + 运行结果”这种完善的结构进行讲解的。此外,复杂的案例配有项目结构图,有难度的案例还分析了底层源码,并且对于所有案例的讲解,都考虑到了读者可能会遇到的各种问题。

● 案例经典实用

本书中的案例大多是由真实项目简化而来的,既体现了所述知识点的精华,又屏蔽了无关技术的干扰。此外,本书在案例讲解时,也充分考量了相关知识的各种实际应用场景,将同一个技术在多个场景下的不同角色都做了充分的讲解。

● 进阶的必学技术一网打尽

本书讲解的爬虫分析、发送请求、数据提取、数据存储、并发爬虫和分布式爬虫等技术是每一位爬虫程序员在进阶路上的必学知识。本书将这些技术的核心要点进行了深入细致的讲解,可以帮助读者尽快取得技术上的突破。

● 系统讲解前沿稀缺知识

本书中介绍的Selenium和Scrapy等技术,均被国内外各大互联网公司大量使用,但目前这些技术的相关资料却少之又少,实战型的书籍更是匮乏。本书对这些学习资源相对稀缺,但同时又是经典必学的知识进行了较为系统的讲解,非常有助于读者快速提升自己已有的知识体系。

● 文字通俗易懂

本书的作者不仅有着多年的开发经验,还承担过多年的技术讲师及教学管理工作,非常擅长用清晰易懂的文字阐述各种难点技术。

内容简介

《Python 3.x网络爬虫从零基础到项目实战》介绍了如何使用Python来编写网络爬虫程序,内容包括网络爬虫简介、发送请求、提取数据、使用多个线程和进程进行并发抓取、抓取动态页面中的内容、与表单进行交互、处理页面中的验证码问题及使用Scrapy和分布式进行数据抓取,并在最后介绍了使用本书讲解的数据抓取技术对几个真实的网站进行抓取的实例,旨在帮助读者活学活用书中介绍的技术。

本书提供了与图书内容全程同步的教学录像。此外,还赠送了大量相关学习资料,以便读者扩展学习。

本书适合任何想学习Python爬虫的读者,无论您是否从事计算机相关专业,是否接触过Python,均可以通过学习本书快速掌握Python爬虫的开发方法和技巧。

本书提供了与图书内容全程同步的教学录像。此外,还赠送了大量相关学习资料,以便读者扩展学习。

本书适合任何想学习Python爬虫的读者,无论您是否从事计算机相关专业,是否接触过Python,均可以通过学习本书快速掌握Python爬虫的开发方法和技巧。

作者简介

史卫亚,博士,副教授,IEEE会员,CCF会员,INNS会员。2009年获得复旦大学计算机应用专业博士学位。2015—2016年在美国北卡罗来纳大学做访问学者,对机器学习、大数据检索、数据库、图像和视频处理、人工智能和模式识别等有深入研究。

![《全国计算机等级考试模拟考场》[71M]百度网盘|pdf下载|亲测有效](/365baixing/uploads/s0309/59d62faeab796a69.jpg)

![《网络规划设计师考试全程指导》[41M]百度网盘|pdf下载|亲测有效](/365baixing/uploads/s0309/aaaf89de770c7905.jpg)

![《 AI剪辑师手册:剪映短视频制作从入门到精通 一本书精通剪映AI热门短视频制作》[65M]百度网盘|pdf下载|亲测有效](/365baixing/upload/2025-03-08/29756605-1_w_1739331302.jpg)

![《Unity3D游戏开发实战:人气游戏这样做》[43M]百度网盘|pdf下载|亲测有效](/365baixing/uploads/s0309/55b09e7bN9a5aeb64.jpg)